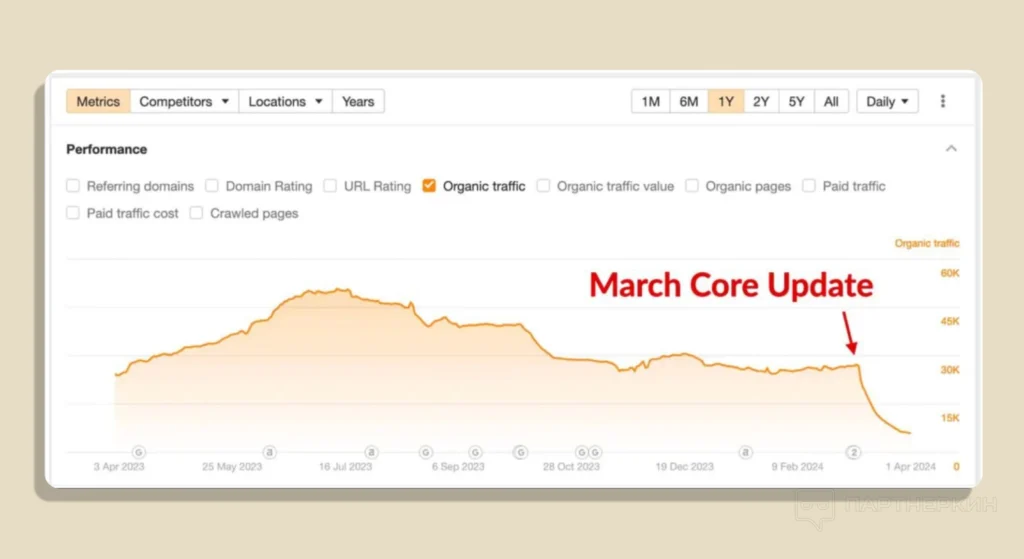

Para que los sitios web sean rentables mucha gente escribe textos optimizados para SEO. Bueno, sí, todo el mundo necesita tráfico. La inteligencia artificial se convirtió en una panacea durante algún tiempo. Pero hace un tiempo, Google decidió tomar el control de todo esto y lanzó otra actualización principal.

Como las cookies de terceros, la actualización ha sido recibida de forma ambigua: algunos se han beneficiado de ella, sobre todo sitios con un enfoque temático muy limitado. Al mismo tiempo, hay una cantidad significativa de proyectos que se han visto gravemente afectados. Algunos dicen que ha supuesto un colapso para el negocio de muchos webmasters independientes. Por ejemplo, el tráfico y los ingresos de sitios como retrododo.com y housefresh.com han disminuido en más del 85%, lo que ha puesto al negocio al borde del colapso.

¿Qué novedades trae esta actualización y cómo puede influir el posicionamiento de las características de sitios web? Tenemos opiniones de especialistas en SEO que pueden ayudarte a mantener tu tráfico si ha disminuido después de estas actualizaciones.

¿Qué es lo que quiere Google?

Al principio quiere mejorar la calidad de los resultados de búsqueda. Google intenta “eliminar” el contenido inútil. Para lograrlo, ha implementado nuevas políticas antispam que apuntan a prevenir tres métodos comunes:

El mal uso de dominios antiguos

Se trata de la compra de dominios antiguos o dominios expirados para colocar contenido orientado al tráfico SEO. Los webmasters confían en que los motores de búsqueda clasifiquen estos sitios en los primeros puestos debido a la autoridad previa de los dominios.

Por ejemplo, comprar el dominio de un sitio web que antes era para médicos y llenarlo con textos sin sentido sobre casinos. El motor de búsqueda identifica y penaliza dichos sitios web.

Al mismo tiempo, se permite la compra de dominios drop siempre que los sitios web creados contengan contenido útil para los usuarios.

La creación de contenido inútil a gran escala

Se trata de sitios web que producen una gran cantidad de textos similares con el objetivo de mejorar el ranking en los motores de búsqueda. En este caso, no importa quién sea el autor del material: si es un humano o una IA.

Google ya tenía reglas contra el spam automatizado. Ahora, la política se ha endurecido y se prohíbe cualquier material que sirva para manipular los motores de búsqueda.

El abuso de reputación de sitios web o SEO “parasitario”

Esto ocurre cuando se coloca contenido de terceros en un sitio web autorizado, como anuncios, materiales de asociación y otro contenido sin el control adecuado. Los webmasters intentan eludir el motor de búsqueda y aumentar la visibilidad del recurso en los resultados de búsqueda.

El hecho de colocar contenido de terceros no está prohibido. Muchos sitios publican materiales publicitarios; esto es una práctica normal si se hace de forma transparente para la audiencia.

El problema surge cuando dicho contenido se coloca sin control, sin beneficio para los usuarios. El objetivo principal aquí es manipular los resultados de búsqueda utilizando la autoridad del sitio original.

Google tiene la intención de encontrar y eliminar activamente este tipo de infracciones. Los sitios web que contengan spam se degradarán en los resultados de búsqueda o se excluirán de ellos.

¿Qué dicen los webmasters?

Se imponen sanciones rápidas:

La nueva actualización impone sanciones a los sitios que infrinjan las reglas. Se ha provocado una ola de preocupación entre los webmasters, que no entienden por qué sus sitios han desaparecido de los resultados de búsqueda.

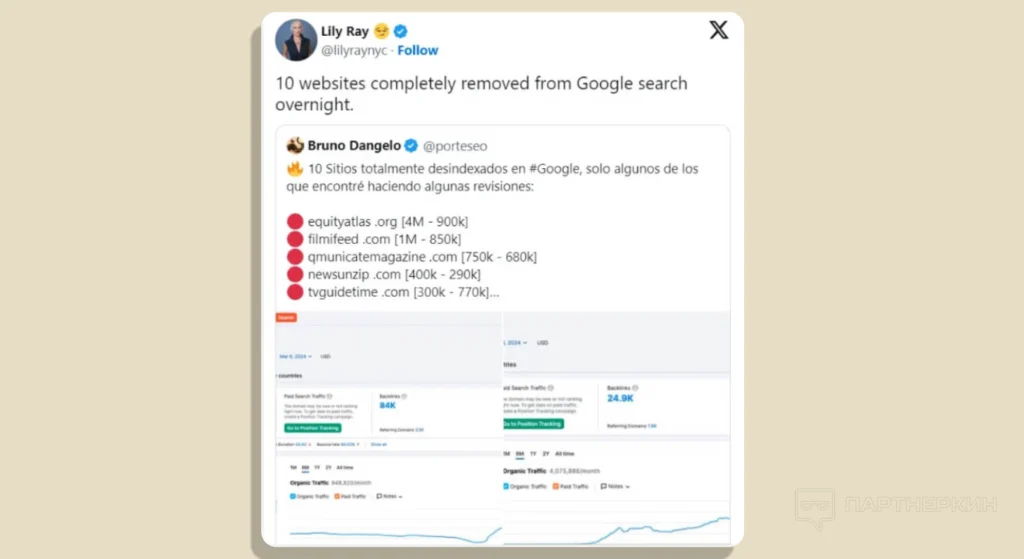

La especialista en SEO Lily Ray mencionó en “X” que más de una docena de sitios desaparecieron repentinamente en un día.

Hay que saber que Google ya no notifica a los propietarios de sitios sobre sanciones a través de Google Search Console.

Se elimina la indexación del sitio web por completo:

Los webmasters temían sobre todo que los sitios web fueran eliminados por completo del índice. Esto afecta a los recursos con contenido irrelevante o de baja calidad.

El especialista en SEO Jeff Coyle señala en “X”:

“Sigo los resultados de búsqueda de un grupo de sitios spam que han ido aumentando lentamente durante el último año. Muchos de ellos han sido eliminados por completo, mientras que otros han bajado significativamente”.

Se impacta sitios web pequeños con contenido de IA:

La actualización también afectó a los sitios pequeños que utilizan activamente la IA. El algoritmo identifica este tipo de contenido y baja sus posiciones en los resultados de búsqueda.

Craig Griffiths, el especialista en SEO, cree que la frecuencia de las publicaciones es uno de los principales indicadores del contenido de IA. Aunque no está seguro de cómo lo hacen, pero siempre salta a la vista cuando en un sitio web se publican 5 mil artículos al día y abusan la API de Search Console para indexación.

El objetivo de Google no es combatir todo el contenido de IA, sino excluir materiales inútiles y repetitivos de los resultados de búsqueda, independientemente de si fueron creados por un humano o un programa.

Esta actualización quita sitios spam e innecesarios de los resultados y promueve recursos de alta calidad.

Se afecta al contenido útil:

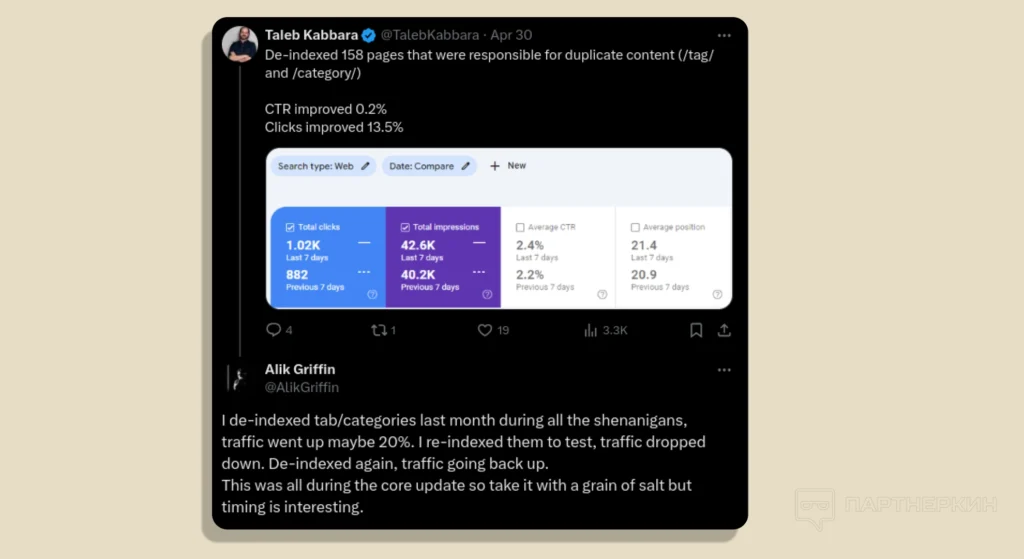

Otros especialistas en SEO, Taleb Kabbara y Alec Griffiths, descubrieron algoritmos que buscan contenido duplicado. Por ejemplo, Alec analiza lentes de cámaras, sus accesorios y compara tarjetas de memoria en uno de sus sitios web.

Después de auditar el sitio, descubrió que tenía datos duplicados en las tablas (duplicación y optimización excesiva de palabras clave). El sitio usaba plantillas para crear numerosas páginas para diferentes modelos de cámaras y accesorios, y parte del contenido se repetía de una página a otra.

Las evaluaciones comparativas para tarjetas de memoria se vieron particularmente afectadas, ya que a menudo usan los mismos datos en diferentes secciones.

Después de auditar el sitio, Alec eliminó las páginas duplicadas del índice para ver cuánto afectaría al tráfico.

Resultados:

- Desindexación inicial: el tráfico aumentó un 20%;

- Reindexación: cuando volvió a agregar estas páginas al índice, el tráfico volvió a caer;

- Redesindexación: después de desindexar las páginas nuevamente, el tráfico volvió a aumentar.

Parece que los algoritmos penalizan a los sitios incluso por la duplicación involuntaria de contenido.

“Reconstruí todas mis tablas, reduje la cantidad de datos duplicados y las reorganicé para que se repitieran con menos frecuencia”, continúa Alec Griffiths. Esto ayudó a reducir el impacto negativo de la duplicación.

Conclusión: ¿Cómo recuperar el tráfico SEO?

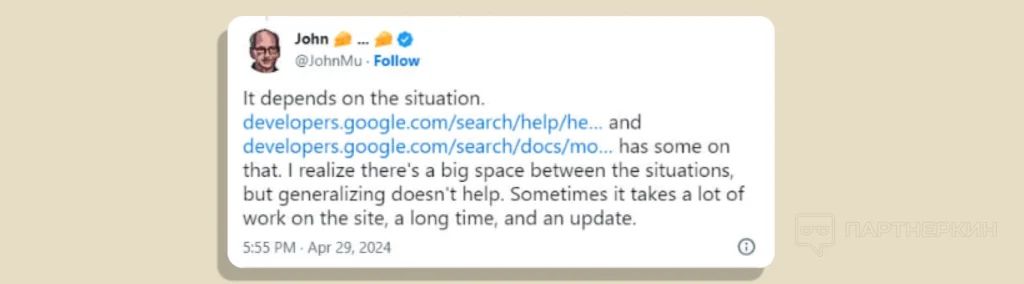

Los propietarios de sitios web y los especialistas en SEO llevan mucho tiempo esperando una aclaración por parte de Google sobre cómo recuperar posiciones tras los cambios de algoritmo. John Mueller, un especialista en búsquedas de Google, ha aportado sus comentarios. En su opinión, la recuperación de posiciones puede llevar mucho tiempo. En algunos casos, puede llevar varios meses, y para resolver problemas graves será necesaria la siguiente actualización del algoritmo.

Teniendo en cuenta la reciente actualización y los estrictos requisitos de Google, los propietarios de sitios web deben abordar esta situación con la máxima seriedad. A continuación, se ofrecen algunas recomendaciones básicas:

- Comprueba todo el contenido de tu sitio. Identifica las páginas con información de baja calidad, poco útil o poco original. Dichos materiales deben ser reelaborados a fondo o eliminados por completo.

- Crea contenido valioso y útil para los usuarios. Escribe textos originales, únicos y atractivos que satisfagan las necesidades de tu público objetivo.

- Elimina todos los métodos de promoción “grises”. Esto incluye la compra de enlaces, el aumento artificial del número de visitas, la generación automática de textos y otras técnicas para manipular los motores de búsqueda.

- Utiliza las herramientas de inteligencia artificial para escribir textos con precaución. No confíes completamente en ellas. El contenido debe ser original, verificado y complementado con intervención humana.